Duas ferramentas desenvolvidas por pesquisadores da Universidade de Chicago e disponibilizadas gratuitamente prometem proteger artistas que não querem que suas obras sejam utilizadas para o treinamento de algoritmos de inteligência artificial generativa: Glaze e Nightshade. As duas alteram as imagens originais de maneira quase imperceptível para olhos humanos, mas o suficiente para atrapalhar completamente sua compreensão pelos modelos de IA generativa.

O Glaze tem como objetivo evitar que o estilo de um artista seja copiado pelos modelos de IA generativa. Muitos deles permitem que, ao colocar o nome de um artista no prompt, o usuário seja capaz de gerar uma imagem no estilo daquele artista. Esse é um dos impactos da tecnologia que mais incomoda o meio artístico.

Na página de apresentação do Glaze, os pesquisadores justificam: “A imitação de estilo produz uma série de resultados prejudiciais que podem não ser óbvios à primeira vista. Para os artistas cujos estilos são intencionalmente copiados, não apenas eles veem perda em comissões e renda básica, mas cópias sintéticas de baixa qualidade espalhadas online diluem sua marca e reputação. Mais importante: os artistas associam seus estilos à sua própria identidade. Ver o estilo artístico pelo qual trabalharam anos para desenvolver sendo usado para criar conteúdo sem seu consentimento ou compensação é semelhante ao roubo de identidade. Finalmente, a imitação de estilo e seus impactos sobre artistas bem-sucedidos desmoralizam e desincentivam jovens artistas aspirantes”.

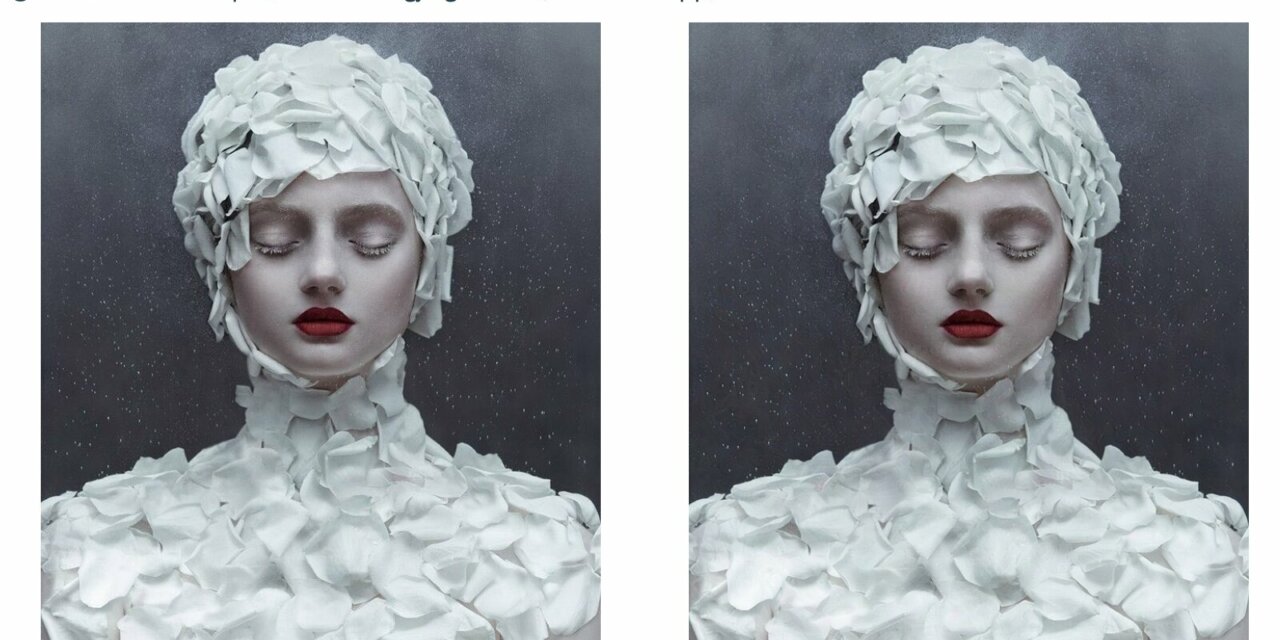

Ao aplicar o Glaze sobre a imagem original, uma nova é gerada, agora protegida contra IA. Para olhos humanos, praticamente não há diferença entre as duas imagens (veja o exemplo no alto desse texto: a imagem da esquerda é a original e a da direita, com Glaze aplicado). Mas o modelo de IA verá algo completamente diferente. Os pesquisadores citam o seguinte exemplo: um desenho realista feito com carvão pode parecer uma obra abstrata a la Jackson Pollock para a IA. Desta forma, se alguém pedir para o motor de IA generativa criar uma imagem ao estilo do artista da obra original feita com carvão obterá um resultado muito diferente do esperado.

Vale destacar que o efeito gerado pelo Glaze permanece ativo mesmo se for tirado um print screen ou mesmo uma foto da tela da imagem alterada. “Pense no Glaze como uma nova dimensão da arte, uma que os modelos de IA veem, mas os humanos não (como a luz ultravioleta ou frequências ultrassônicas), exceto que a própria dimensão é difícil de localizar, calcular, ou descobrir por engenharia reversa. A menos que um ataque saiba exatamente em que dimensão o Glaze opera – só que ela muda em cada obra de arte –, será difícil interromper os efeitos do Glaze”, explicam os pesquisadores.

Nightshade

O Nightshade, por sua vez, foi desenvolvido com o propósito de atrapalhar o processo de identificação de objetos específicos no processo de treinamento dos modelos de IA generativa. Ele também altera a imagem original de maneira imperceptível a olho humano, mas capaz de levar o algoritmo a enxergar algo completamente diferente. Por exemplo, uma vaca pastando poderia ser vista como uma bolsa de couro repousada sobre a grama.

Contudo, para ter efeito, o Nightshade precisa ser utilizado coletivamente. Se vários artistas aplicarem essa ferramenta em suas obras disponibilizadas online, podem fazer com que o modelo de IA passe a confundir certos objetos.

A Universidade de Chicago sugere que Glaze e Nightshade sejam aplicados conjuntamente nas obras. O primeiro evita a cópia do estilo do artista, e o segundo atrapalha o treinamento de identificação de objetos pelos modelos de IA. Os pesquisadores prometem em breve juntar os dois softwares, fazendo do Nightshade uma espécie de add-on para o Glaze.

Os pesquisadores reconhecem que os modelos de IA podem contornar os impactos do Nightshade, aprimorando seus algoritmos, mas a ideia é justamente exigir mais trabalho e custo nesse processo para, quem sabe, obrigar essas empresas a negociarem o licenciamento de conteúdo para treinamento.

Análise

A utilização de conteúdo online para treinamento de modelos de IA generativa sem a autorização, muito menos a remuneração, dos autores é uma das grandes questões em debate hoje em dia depois do advento do ChatGPT e afins. Alguns grandes jornais e editoras de livros têm judicializado o assunto, como fez o New York Times. Outros procuram incluir dentro de seus sites avisos informando que não autorizam que seu conteúdo seja usado dessa forma. Só que esses avisos nem sempre são respeitados. Por conta disso, ferramentas como Glaze e Nightshade servem, no mínimo, como um paliativo, protegendo um pouco mais os artistas e suas obras.

Crédito da imagem no alto: reprodução do site do Glaze com obra da artista Jingna Zhang. A imagem da esquerda é a original e a da direita tem o Glaze aplicado