O Google colocará realidade aumentada nos resultados de pesquisas em seu buscador. O anúncio foi feito pela VP do Google Lens e AR, Aparna Chennapragada, durante o Google I/O 2019. Os novos recursos da Pesquisa do Google usam câmera, visão computacional e realidade aumentada (AR) para sobrepor conteúdo ao ambiente real. A novidade chega até o final do mês.

Com os novos recursos de AR em Pesquisa será possível visualizar e interagir no espaço físico onde está o usuário. A VP deu alguns exemplos diferentes de como suas opções de pesquisa de AR podem funcionar. Ao procurar por “musculatura”, por exemplo, o usuário encontrará um modelo de músculos humanos e, ao clicar no ícone, poderá examiná-lo como um objeto 3D comum na tela do celular ou usar o recurso de AR e “vê-lo” no mundo real.

Outro exemplo foi o de um par de tênis. Ao olhar para os resultados de compras, será possível visualizar uma peça de roupa ao lado de peças de roupas reais para ver se combinam.

Por fim, como último exemplo, Chennapragada buscou um tubarão no Google e o inseriu, via realidade aumentada, no palco. Ao pesquisar por animais, o usuário terá uma opção no Painel de conhecimento para visualizá-los em 3D e AR.

Tudo indica que a opção de ver os objetos em AR 3D estará disponível nos resultados de pesquisa do Google no fim deste ano.

Google Lens

De acordo com a empresa norte-americana, já foram feitas mais de 1 bilhão de perguntas ao Google Lens. A lente usa aprendizado de máquina, visão computacional e dezenas de bilhões de fatos do Knowledge Graph para responder a essas perguntas. Mas, durante o I/O, a empresa anunciou o desenvolvimento do Google Lens para fornecer respostas mais visuais para perguntas também visuais.

Um exemplo dado foi em um restaurante. O usuário pode usar o Google Lens para procurar um prato no cardápio para pedir. Quer dizer, a pessoa abre a câmera, a ponta para o menu e o celular dará opções para ela pedir. E, ao clicar em um prato, será possível vê-lo pronto e o que as pessoas estão dizendo sobre ele, graças às fotos e os comentários do Google Maps.

Para chegar a esse produto final, o Lens primeiro tem que identificar todos os pratos no menu, procurando coisas como fonte, estilo, tamanho e cor para diferenciar os pratos das descrições. Em seguida, ele faz a correspondência dos nomes dos pratos com as fotos e resenhas relevantes para esse restaurante no Google Maps.

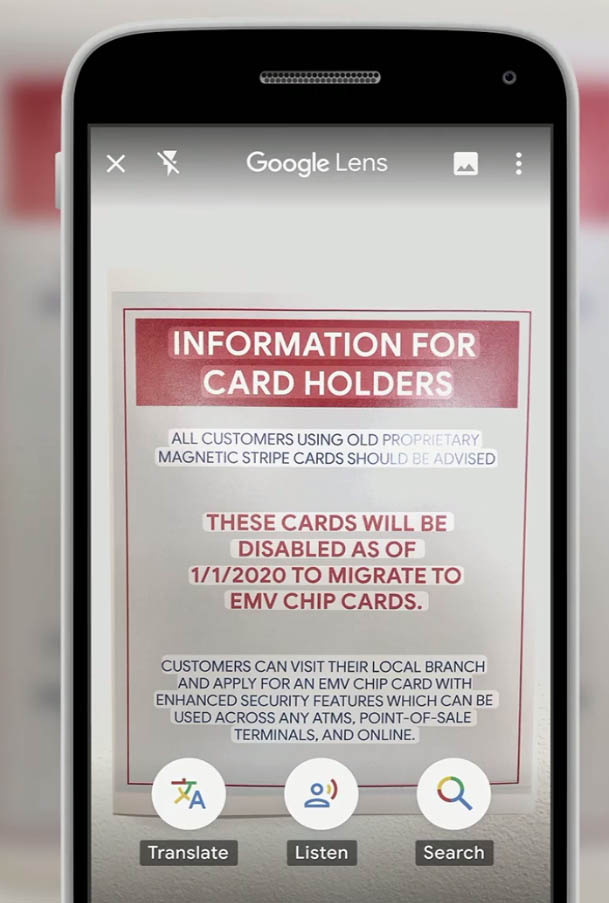

Tradução

Outro recurso do Lens será útil para quem não sabe ler propriamente ou está diante de um sinal em uma língua desconhecida. Para desvendar o que está escrito, o usuário aponta a câmera para o texto e o Lens detectará automaticamente o idioma e sobreporá a tradução em cima das palavras originais. A ferramenta estará disponível em mais de 100 idiomas.

O recurso também pode ler em voz alta o texto. O Google Lens destaca as palavras à medida que são faladas, para que o usuário possa acompanhar e entender o contexto completo do que vê.

Este recurso está sendo lançado primeiro no Google Go, aplicativo de pesquisa para usuários iniciantes de smartphones. “O Google Lens no Google Go tem pouco mais de 100 KB e funciona em telefones que custam menos de US$ 50”, explicou Chennapragada durante sua apresentação.