O Brasil tem mais de 50 grandes modelos de linguagem (LLMs) em português. O mapeamento foi apresentado por Anderson Soares, professor da Universidade Federal de Goiás (UFG) e gerente geral do Centro de Excelência em Inteligência Artificial (CEIA-UFG) durante workshop para imprensa realizado no Itaú em São Paulo, nesta terça-feira, 25.

Soares explicou que esses LLMs estão sendo construídos desde 2020 e vêm evoluindo desde então. O levantamento cita especificamente:

- 2020 – BERT-CRF, PTT5, ElMo e BERT para documentos legais, BERTimbau e BioBERTPT;

- 2021 – RobertaTwitterBR, GPortuguese-2, GPT-2 Bio PT, mRAT SQL-GAP, BERTaú e BertBR;

- 2022 – PetroBERT, ZeroBERTo, BERT for Legal NER e PTT5-Paraphrasrer;

- 2023 – Canarim, Caramelo, Caramelinho, Harpia, Aira-2, Alpaca-lora-ptbr, Sabiá, BERTabaporu, LegalBert-pt, DeBERTinha, Cabrita, Open Cabrita, Albertina PT e JurisBERT;

- 2024 – Samba, Boana, Mula, Manbarim, Cabra, TeenyTinyLlama, PellE, Sabiá-2, Sabiá-3, Bode, RoBERTaLexPT, Juru, Ppt5v2, Mono T5, Gervácio e Tucano;

- 2025 – Gaia, Amadeus-Verbo, BertTweet.Br e DeB3rta.

Em conversa com jornalistas, o professor explicou que o CEIA colaborou para a construção de muitos desses modelos, inclusive seis deles foram feitos em 2020, antes do estopim da IA generativa com a OpenAI e o ChatGPT.

“[Os LLMs] são todos de retreinamentos de redes neurais ou treinos do zero. Tem as duas coisas misturadas, mas são contribuições científicas que aconteceram no Brasil fazendo essa tarefa”, disse. “Isso parece bom e interessante, mas, de fato, é um pequeno retrato das derivações de modelos muito maiores do que vem acontecendo na língua inglesa e ao redor do mundo. Portanto, quando olhamos no comparativo, obviamente nós temos um volume de um impacto menor em relação a tudo que aconteceu”, detalhou.

Soares afirmou que a maioria desses modelos nacionais não são conhecidos por funcionarem com aplicações específicas, como LLM para o setor jurídico ou LLM para o setor de óleo e gás. Cita inclusive modelo criado em 2018 para criar anúncios publicitários na UFG. A diferença é que esses modelos de linguagem são menos complexos ante os LLMs generalistas.

“Quanto mais generalista, maior e mais complexa é a construção de um LLM”, disse. “A novidade é que agora você consegue conversar com IA generativa sobre culinária, astronomia e varejo, por exemplo. Mas quanto mais generalista, mais complexa. Portanto, há uma troca entre generalização e especificidade que é comum. É que quando se generaliza, a LLM atinge um público muito maior”, completou.

Racionalidade, o salto da IA

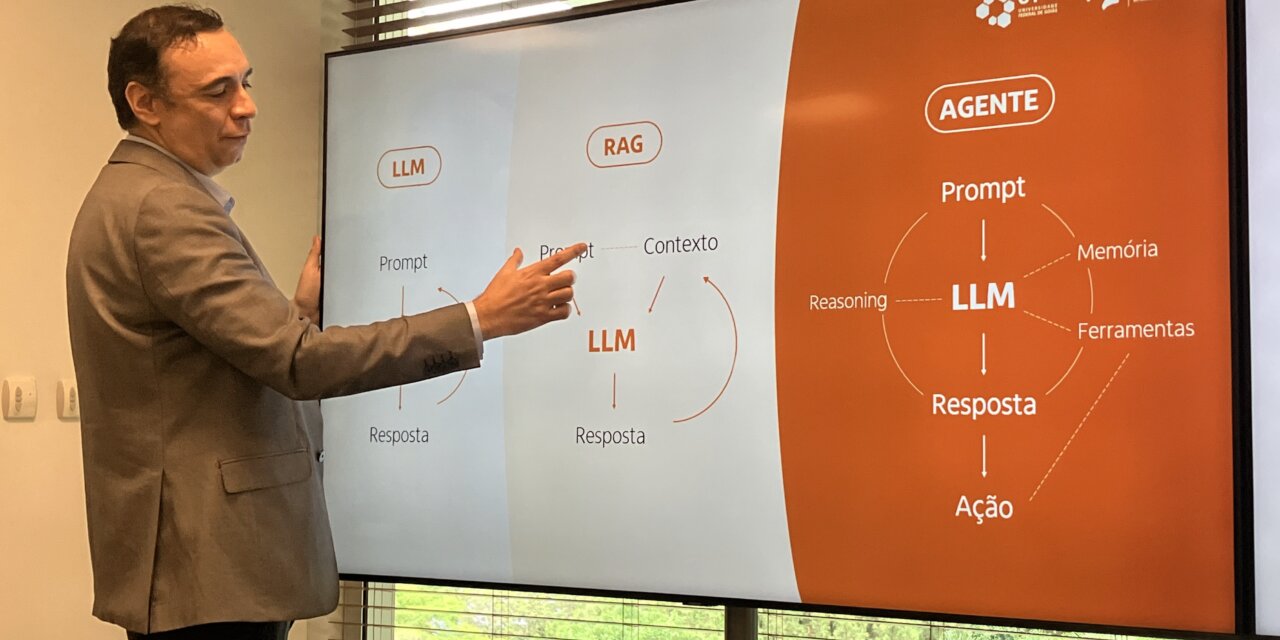

O professor da UFG explicou que o grande salto da IA pela ótica da academia foi em 2025 com a inclusão do raciocínio (reasoning, no original do inglês). Isso permitiu às aplicações evoluírem de darem respostas aos usuários para gerarem ações, ou seja, os agentes de IA.

Esse processo de adoção na IA generativa começa com LLMs, depois LLMs com RAG e agora a IA com racionalidade, com memória e ferramentas para tomar uma ação: “Isso evoluiu muito rápido (entre 2022 e 2025). Na ciência, nós trabalhamos com evoluções em décadas, não em anos. Até então, nem o LLM mais poderoso resolvia 5% das tarefas de benchmark até 2024”, disse.

Porém, o especialista acredita que há desafios na aplicação da racionalidade nos LLMs. Em especial, a habilidade de captar os benchmarks gerados em testes científicos para convertê-los em aplicações que resolvam problemas nas mais diferentes indústrias.

Ainda assim, acredita que o reasoning está em sua primeira etapa e tem muito para avançar. Também crê que a IA deva avançar mais para multimodelos de LLM: “O texto foi um passo básico. Agora, começamos a integração entre texto e imagem, mas os ambientes precisam combinar áudios, imagens, textos e realizar a ação com racionalidade. Ainda estamos nos passos básicos no campo científico em multimodal”, relatou.

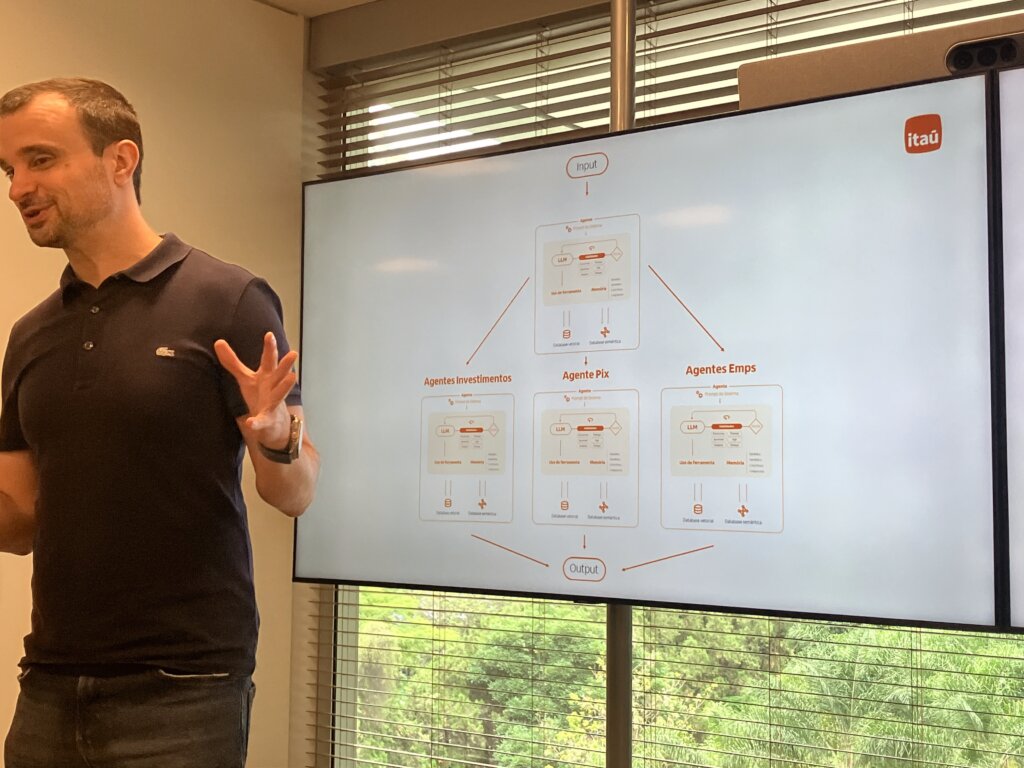

Como parceira da CEIA, o Instituto de Ciência e Tecnologia do Itaú (ICTi) vê possibilidades com o uso de agentes, a partir de sua maturidade. Conforme explicou Rogério Lopes, líder de IA e ciência de dados no ICTi, os agentes podem avançar para:

- Pagamentos automatizados inteligentes;

- Investimentos personalizados;

- Planejamento financeiro;

- Renegociação proativa em dívidas.

Mas o executivo vê desafios no balanço entre a autonomia dos agentes e o controle do cliente.

Cultura agêntica

Carlos Eduardo Mazzei, diretor de tecnologia do Itaú (crédito: Henrique Medeiros/Mobile Time)

Prevendo que haverá um “exército de agentes” com propósitos diversos para ajudar o cliente no futuro, o diretor de tecnologia do Itaú, Carlos Eduardo Mazzei, afirmou que a governança de dados e a tecnologia não são problemas hoje. Isso porque a estrutura está montada com o Itaú Data Mesh, um modelo de fundação do banco que está presente na nuvem da AWS e que é estendido para os agentes terem regras de orquestração e atuação, como quais autorizações e quais sistemas um agente tem permissão.

Mas Mazzei afirmou que o desafio é principalmente cultural e a prontidão do ser humano em lidar com isso, algo similar à transformação digital iniciada há duas décadas: “Muitas vezes há processos de negócio que foram estabelecidos lá atrás que são adequados para o humano usar. Temos que repensar como esses processos funcionam. Quando a gente teve a transformação digital, falávamos que não era sobre tecnologia. Posso afirmar aqui: a transformação da IA também não é sobre tecnologia. É sobre a prontidão do ser humano em aprender e incorporar essa tecnologia no nosso dia a dia para tirar proveito dela”, prevê.

“Essa não é um uma barreira cultural pequena, porque muda o hábito das pessoas, muda como consumimos o produto, por exemplo. Então, a cultura é mais complexa do ponto de vista transformacional que a governança em si. A governança nós aprendemos a operar em cloud e em governança distribuída. Está mais bem equacionada”, concluiu.

Neste cenário, Mazzei afirmou que a maturidade da IA e a adoção da tecnologia ajudam a avançar com os agentes. Deu como exemplo a solução de Pix no WhatsApp do Itaú que gerou redução de dez vezes nos custos de processamento em 2025, ante seu lançamento um ano antes.

Imagem principal: Anderson Soares, professor da UFG e gerente geral na CEIA (crédito: Henrique Medeiros/Mobile Time)