A Meta anunciou nesta quinta-feira, 11, novas medidas para proteger adolescentes de mensagens diretas (conhecido também por “direct” ou “DM”) que contêm nudez no Instagram (Android, iOS). O recurso irá desfocar imagens de nudez em contas de menores de idade de modo automático. Os adultos receberão notificações sobre a nova funcionalidade e serão incentivados a ativá-la.

A proteção usará machine learning (ML) no dispositivo para identificar se a imagem enviada na DM contém nudez ou não. De acordo com a empresa, as imagens são analisadas no próprio dispositivo. Por isso, a medida funcionará em conversas criptografadas de ponta a ponta, nos quais a Meta não tem acesso a essas imagens – a menos que alguém decida denunciá-las para a big tech.

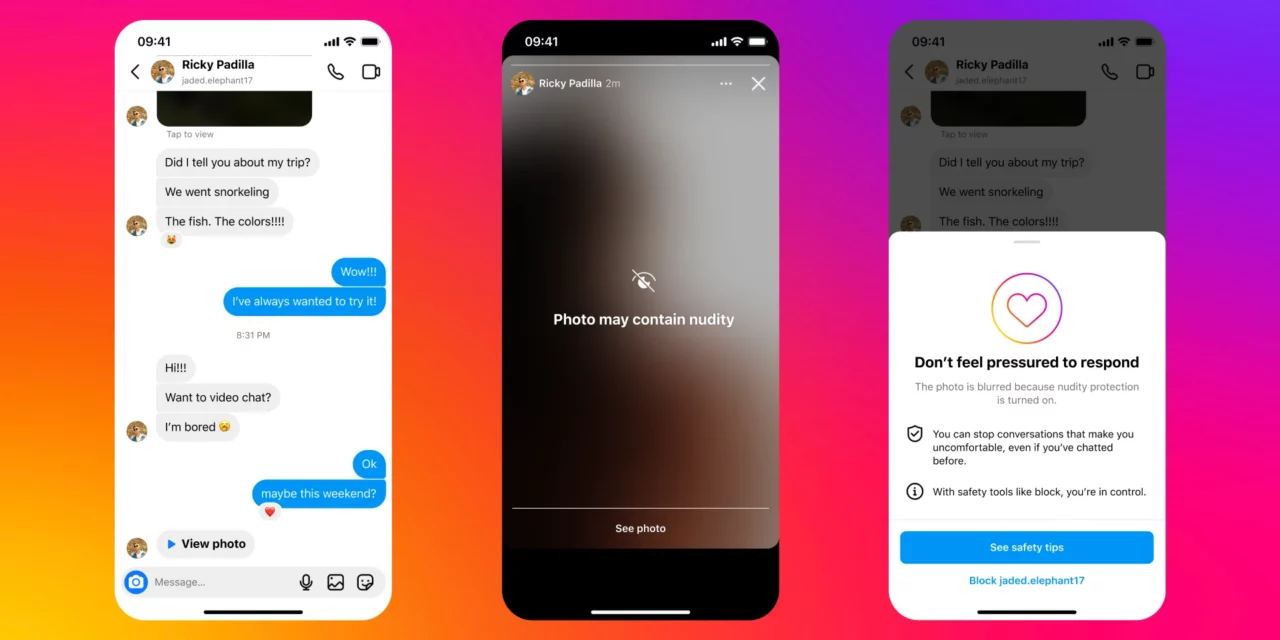

“Quando alguém recebe uma imagem contendo nudez, ela fica automaticamente desfocada em uma tela de aviso, o que significa que o destinatário não é confrontado com uma imagem de nudez e pode escolher se deseja ou não visualizá-la. Também mostraremos uma mensagem incentivando-os a não se sentirem pressionados a responder, com a opção de bloquear quem enviou e denunciar o bate-papo”, explicou a empresa em comunicado. O aviso será enviado ao remetente e destinatário para conscientizá-los da “sextorsão”.

A função foi feita também para outras formas de abuso de imagens íntimas, como proteger os usuários de fraudes em que, quem recebe, segundo a Meta, é estimulado a mandar seus próprios nudes. Além disso, a companhia está desenvolvendo tecnologias com o objetivo de ajudar a identificar quais são as contas que podem estar potencialmente envolvidas em golpes de sextorção.