Imagine se fosse possível termos múltiplos cérebros, cada um especializado em uma tarefa diferente. Para a escrita, o cérebro de um escritor, para cálculos, o de um matemático, e assim por diante. É assim que os novos bots e agentes de IA estão sendo construídos. Eles trabalham acessando múltiplos modelos de linguagem, de acordo com a tarefa a ser cumprida e com critérios como acurácia, latência, memória e, claro, custo. São projetos multi-LLM, cujo sucesso depende da sua arquitetura e da constante reavaliação dos modelos usados. Nos últimos meses, diversas grandes empresas e desenvolvedores de bots aderiram a essa abordagem em seus projetos com interface conversacional.

Trabalhar com múltiplos LLMs é uma estratégia que surgiu como consequência da proliferação de modelos de linguagem de diferentes fornecedores, como GTP, Gemini, Llama, Claude, DeepSeek e Grok. Isso sem falar na variedade de modelos de um único fornecedor. O recém-lançado GPT-5 da OpenAI, por exemplo, tem as versões padrão, thinking, pro, mini e nano.

Diego Quadros, do Banco do Brasil (Crédito: reprodução da Internet)

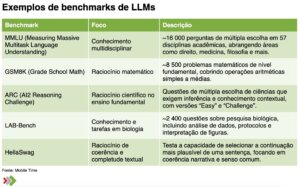

Cada modelo de linguagem de cada fornecedor pode ser mais ou menos habilidoso para o cumprimento de tarefas em áreas de conhecimento distintas. Para compará-los, surgiram inúmeros testes internacionais. Entre os mais conhecidos estão MMLU (Massive Multitask Language Understanding), que mede o conhecimento geral em 57 áreas, incluindo matemática básica, história, ciência da computação e direito; HellaSwag, que avalia o senso comum em linguagem natural; ARC (A12 Reasoning Challenge), com perguntas complexas de ciência; TruthfulQA, que avalia taxa de erro em 38 temas; WinoGrande, de linguagem, para medir capacidade de compreensão de frases ambíguas; GSM8K, com 8,5 mil perguntas de matemática elementar; e MATH, com 12,5 mil problemas matemáticos.

Em modelos multimodais, o desempenho em computação visual e transcrição de voz também varia. E os resultados podem ser diferentes dentro de um mesmo modelo dependendo do tipo de imagem, alerta Diego Quadros, executivo de experiência de clientes e negócios do Banco do Brasil. “Leitura de ata jurídica é uma coisa, e de imagem de satélite é outra”, exemplifica.

Nicola Sanchez, da Matriz GO (Crédito: divulgação)

Além dos testes de conhecimento, há outros que comparam a velocidade de raciocínio, medida em tokens por segundo; a latência; e o preço, por milhão de tokens. Também foram criados rankings, ou “leaderboards”, que combinam os resultados de vários benchmarks, na tentativa de auxiliar no processo de escolha de modelos. Um bom exemplo é o LLM Leaderboard, que avalia mais de 100 diferentes modelos.

“O mercado está bastante aquecido. Modelos como GPT-4o vêm se destacando em tarefas de raciocínio e interações mais complexas. Claude tem entregado uma linguagem natural refinada, ótima para interações mais sensíveis. Outros, como DeepSeek e Llama, têm chamado atenção pelo equilíbrio entre performance e acessibilidade. Cada um tem seu ponto forte”, comenta Nicola Sanchez, CEO e fundador da Matrix GO.

Critérios para escolha de LLMs

Diante de tantas opções e variáveis, como escolher um ou mais LLMs para uma aplicação? Os benchmarks dão uma orientação básica, mas nada melhor que realizar seus próprios testes, com a sua base de dados e simulando situações reais.

“Partimos do problema de negócios que queremos resolver, fazemos alguns testes e vemos qual LLM responde melhor vis a vis o custo. Somos agnósticos em termos de LLMs. Experimentamos todos disponíveis no mercado”, conta Quadros, do Banco do Brasil.

Hernán Liendo, da Botmaker (Crédito: divulgação)

Na prática, os principais fatores analisados são acurácia, custo, latência, memória e estabilidade.

A acurácia é talvez o mais importante, mas, dependendo da complexidade da solicitação, não é preciso usar um modelo grande. Às vezes, modelos menores entregam o mesmo resultado com menor custo e maior rapidez. Por isso é importante analisar os resultados combinando os diferentes critérios.

Outro aspecto considerado é a forma como cada LLM se expressa, ou como costuma conduzir a conversa. “O estilo da conversa tem algumas assinaturas, um sabor. Gostamos muito do Llama. Ele fala diferente, mais simpático. É melhor para conversas informais, por exemplo”, indica Hernán Liendo, CTO e cofundador da Botmaker.

Embora a maioria dos LLMs funcionem em centenas de línguas, com tradução automática, a qualidade pode variar dependendo do idioma. Logo, a fluência do modelo em Português acaba sendo também um critério a ser levado em conta, apontam fontes.

A latência, por sua vez, pode ser determinante na escolha do LLM para certas aplicações. Ser for um assistente virtual por voz que atenda a chamadas telefônicas, é essencial que a latência seja baixa para que a conversa flua com naturalidade. Outro exemplo é na área de prevenção a fraudes, em que as soluções precisam analisar dados com agilidade para validar transações financeiras. Da mesma forma, aplicações de análise de sentimento durante chamadas a call center que funcionam como um copiloto para o atendente humano precisam entregar suas avaliações e sugestões o mais rapidamente possível.

Wiliam Cole, da Blip (crédito: divulgação)

A latência é influenciada por diversos fatores. Um deles é o tamanho do modelo e o tempo que ele gasta “raciocinando”. “Uma chamada no modelo GPT-o3 demora de 10 a 40 segundos. No GPT-o3 Mini leva 1 a 3 segundos. Isso muda completamente a experiência no desenvolvimento de uma aplicação. Modelos grandes têm mais capacidade, porém demoram mais no processamento”, compara Wiliam Cole, diretor de IA da Blip

Outro fator que impacta a latência é a infraestrutura em que o modelo está instalado. O mesmo modelo pode ter latência menor ou maior dependendo da arquitetura dos sistemas aonde se encontra. E nem sempre a performance é melhor rodando a aplicação localmente. Eventualmente, o desempenho é melhor na nuvem, se esta contar com servidores dotados de chipsets mais potentes que aqueles on-premise.

“Enxergamos os LLMs como uma caixa de ferramentas cada vez mais diversificada. A escolha envolve uma combinação de critérios técnicos e estratégicos — sempre visando o melhor equilíbrio entre performance, confiabilidade, custos e aderência ao idioma”, resume Sanchez, da Matrix GO.

Orquestrando LLMs

Para lidar com o trabalho de seleção de LLMs, muitas empresas contam com profissionais dedicados a essa tarefa, responsáveis por acompanhar o lançamento de novos modelos e realizar testes. Em geral, são engenheiros de inteligência artificial.

O Banco do Brasil conta com uma plataforma própria para testar diferentes LLMs de mercado. Ela nasceu em 2021 para comparar ferramentas de OCR e depois acabou adaptada para testes com modelos de linguagem. Todo mês seus produtos com IA conversacional são testados dentro dessa plataforma com diferentes LLMs para verificar se não seria melhor trocar de modelo. Recentemente, a partir de uma dessas reavaliações, o banco decidiu mudar o LLM de um bot usado pelos seus 90 mil funcionários para pesquisa de procedimentos internos do banco, relata Quadros, do Banco do Brasil.

Para a construção de bots que operam com múltiplos LLMs, é necessário contar com um software que cuide dessa seleção de forma dinâmica dentro de cada conversa. É uma espécie de orquestrador, ou roteador, que analisa a intenção do usuário e encaminha a solicitação para o LLM mais indicado para cuidar dela.

Na Botmaker, o orquestrador de LLMs é chamado de broker. Se um modelo sofrer algum problema operacional, como lentidão ou queda do serviço, o broker troca automaticamente para outro LLM. O preço do token também é acompanhado constantemente e pode determinar uma troca. “O que funciona hoje pode não valer para a semana que vem”, justifica Liendo, da Botmaker.

A Blip, por sua vez, desenvolveu o que chama de “classificador”. Ele identifica a intenção do usuário e decide se deve acionar um LLM com maior ou menor capacidade de raciocínio. Se for uma saudação, por exemplo, nem precisa gastar dinheiro com LLM.

Várias outras empresas seguem a mesma estratégia de não se apegar a um único fornecedor de LLM. “Tentamos ser agnósticos em relação a LLMs. Sempre tem uma camada de software da Zenvia por cima que define qual LLM usar”, afirma Lilian Lima, CTO da Zenvia.

DSLMs, SLMs e LLMs nacionais

Em aplicações focadas em uma determinada área do conhecimento, pode valer a pena construir um modelo de linguagem de domínio específico (DSLM, na sigla em inglês). Ele é treinado com dados sobre o assunto escolhido, tornando-se mais preciso e rápido para requisições relacionadas ao tema.

Um DSLM pode ser criado a partir de um LLM usando um processo conhecido como “destilação”, em que o LLM atua como um professor para o DSLM em construção, que é o “estudante”.

A startup brasileira Resolva AI está construindo seu próprio DSLM, com o objetivo de ganhar velocidade, acurácia e redução de custos na operação do seu agente de IA, que liga para call centers de grandes empresas para resolver problemas em nome dos consumidores. Foi uma decisão estratégica, cuja conclusão deve levar cerca de três anos e consumir aproximadamente R$ 10 milhões de investimento.

Vicente Camillo, da Resolva AI (Crédito: divulgação)

“Nosso modelo vai acumular conhecimento sobre regulação brasileira e sobre a maneira de resolver tíquetes no Brasil. Vai gerar economia, eficácia e eficiência”, afirma Vicente Camillo, CEO e cofundador da Resolva AI.

Mesmo com seu DSLM, a Resolva AI continuará usando agentes diversos para tarefas específicas dentro de sua solução, assim como continuará acessando LLMs, mas em menor quantidade. Para essa gestão de modelos, ela desenvolveu seu próprio orquestrador, que chama de “roteador”.

Outra tendência com o mesmo propósito de reduzir custos, ganhar velocidade e aumentar a acurácia consiste no desenvolvimento de modelos de linguagem de pequeno porte (SLMs, na sigla em inglês). A diferença para o DSLM é que o SLM não necessariamente é focado em uma área de conhecimento específica, mas pode servir para executar tarefas que requerem conhecimento limitado.

“Começamos a usar SLMs no início deste ano e para casos específicos, em que a decisão precisa ser binária. Usamos SLMs para consumir menos tokens e para alucinar menos. Sempre que precisamos de algo mais específico, adotamos SLMs”, relata Quadros, do Banco do Brasil.

Em um banco, a emissão de cartões pode ter um SLM, enquanto operações com Pix, outro, por exemplo. Novamente, a figura do orquestrador é essencial para identificar a intenção do usuário e acionar o LLM ou SLM mais apropriado.

“SLMs têm um papel relevante, especialmente quando buscamos soluções mais ágeis, com menor consumo de recursos e alta previsibilidade. São úteis em contextos específicos, com vocabulário controlado e lógica bem definida. Cada vez mais, veremos ecossistemas híbridos combinando diferentes tipos de modelos — e essa será uma das grandes forças do futuro da IA”, comenta Sanchez, da Matrix GO.

A vantagem de usar SLMs, contudo, não é um consenso no mercado. Liendo, da Botmaker, alerta que o treinamento é difícil e custa caro. “Os testes que fizemos com fine tuning estão longe de ficar como gostaríamos”, relata, mas reconhece que isso deve melhorar conforme a tecnologia avança e fica mais barata.

Edison Figueira, da Fortics (Crédito: divulgação)

Paralelamente, vale mencionar a existência de iniciativas para a construção de LLMs brasileiros, treinados em português com dados da cultura nacional, como o Amazônia IA, da startup Widelabs, e o GAIA, do Google. Para além da importância estratégica para o país, LLMs nacionais podem despertar o interesse de empresas por terem uma compreensão melhor da língua portuguesa e dos sotaques e vocabulários regionais, o que reduziria o risco de alucinações e outros erros. Também podem ter como vantagem o custo mais baixo por cobrarem em Reais, enquanto os LLMs estrangeiros têm preços em dólar.

“Usamos LLMs em dólar, o que é caro. Estamos sempre medindo o retorno sobre investimento (ROI). Poderia ser muito melhor se houvesse um LLM em português, cobrando em Reais”, comenta Edison Figueira, CTO da Fortics.

Futuro dos LLMs

Para o futuro, espera-se que o preço dos tokens continue caindo e que a qualidade dos modelos siga aumentando, em razão da intensa competição nesse mercado, projetam as fontes ouvidas por Mobile Time.

Uma das tendências deve ser a do surgimento de markeplaces de agentes ou modelos especializados em determinadas tarefas ou áreas do conhecimento, prevê Camillo, da Resolva AI.

Cassio Bobsin, CEO da Zenvia. (Crédito: divulgação)

Há também quem espere um movimento de consolidação do mercado de LLMs, tal como aconteceu com tantas outras tecnologias na história do capitalismo. “No fim do jogo vão sobrar três ou quatro opções. Talvez uma open source e duas ou três que vendem LLM como serviço junto com hosting”, avalia Cassio Bobsin, CEO e fundador da Zenvia.

Portanto, podemos esperar que os bots do futuro continuem tendo múltiplos cérebros, com propósitos e tamanhos diferentes… pelo menos até o surgimento de uma Inteligência Artificial Geral (AGI, na sigla em inglês), espécie de “supercérebro”, mas isso é assunto para outra reportagem.

Orquestração de LLMs no Super Bots Experience & Forum de Autoatendimento Digital 2025

Estratégias para orquestração e criação de LLMs e SLMs serão tema de um painel no Super Bots Experience & Forum de Autoatendimento Digital 2025, evento organizado por Mobile Time que acontecerá nos dias 21 e 22 de agosto, no WTC, em São Paulo.

Também haverá painéis sobre IA agêntica, startups AI-native, AI-commerce, regulamentação de IA e estratégia de presença móvel. A agenda atualizada e mais informações estão disponíveis em www.botsexperience.com.br

A ilustração no topo foi produzida por Mobile Time com IA